GPT-4: Der Quantensprung in die Zukunft der Künstlichen Intelligenz

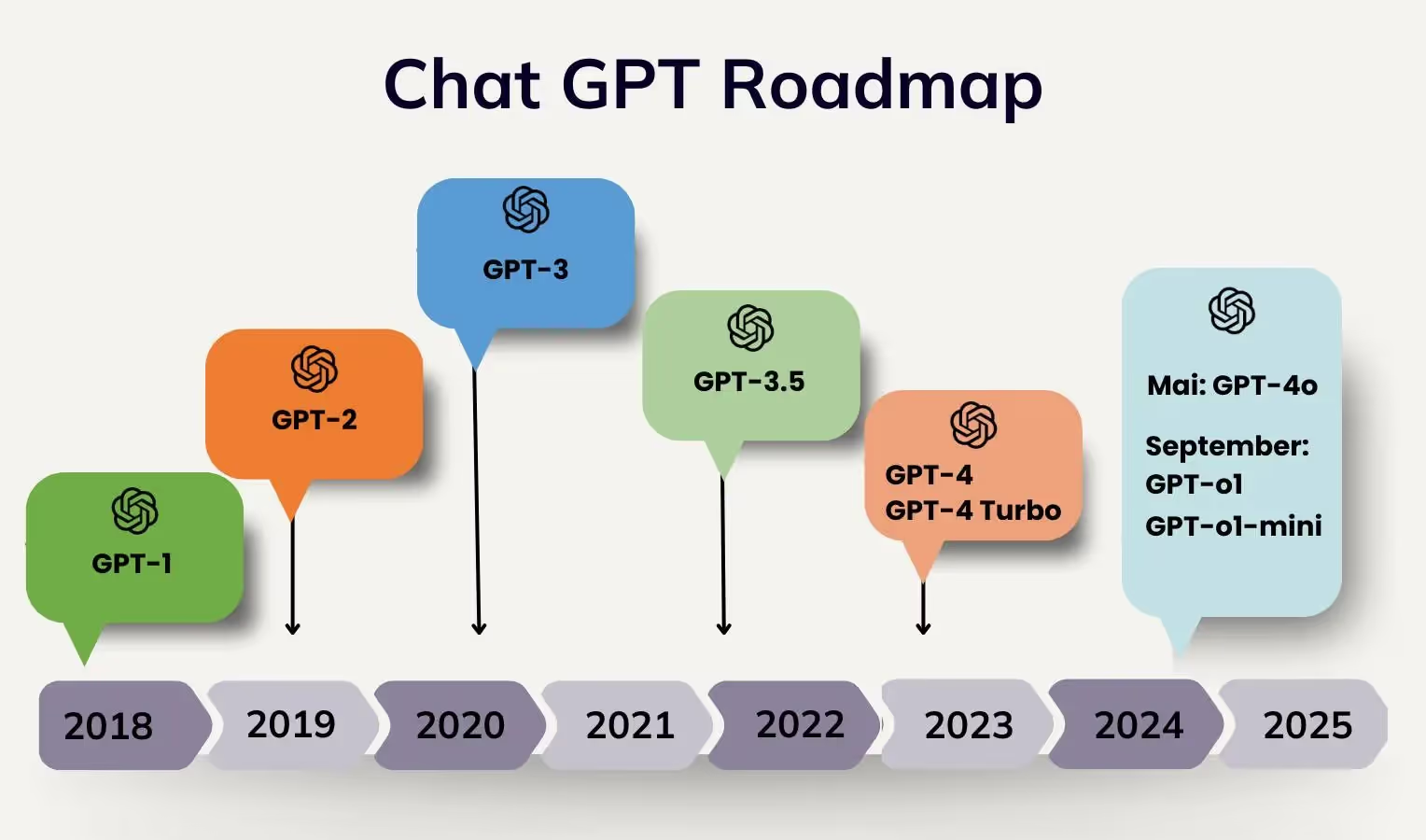

Am 14. März 2023 hat OpenAI die nächste Ära eingeläutet und die neueste Version GPT-4 der Welt vorgestellt. Mit diesem Upgrade hat das KI-Unternehmen den Vorgänger GPT-3 fundiert revolutioniert und neue Features hinzugefügt.

Grundlegender Unterschied zu GPT-3 ist die Erweiterung bezüglich der Erkennung von Bildern in dieser Anwendung. Es ist möglich, Bilder einzufügen und dementsprechend Informationen zu generieren. Ein weiterer Meilenstein ist die Implementierung von GPT-4 in die neue Version der Search Engine Bing von Microsoft. GPT-4 ist 82 % genauer als GPT-3 bei der Beantwortung von Fragen und erfindet seltener Antworten. Somit ist GPT-4 mehr als nur ein Upgrade zu GPT-3, es ist ein Quantensprung in neue Sphären und lässt tief in zukünftige Entwicklungen blicken.

Was ist der Unterschied zwischen GPT-3 und GPT-4?

Um das Ausmaß der Weiterentwicklung von GPT-4 zu verstehen, ist es wichtig, die einzelnen Neuerungen zu beleuchten:

- Durch einen umfangreichen Textinhalt lässt sich mit GPT-4 ein Text im Umfang von 50 Seiten in englischer Sprache verarbeiten. Dadurch können längere Dokumente & Codes zusammengefasst und verarbeitet werden. Außerdem werden Dialoge aufgrund komplexer Erinnerungsvermögen optimiert. Folgerichtig vergisst das Modell weniger und kann ausgiebiger mit Prompts arbeiten.

- Mit verbessertem Denkvermögen übertrifft die neueste Version seine Vorgängervariante abermals. Hierbei beweist GPT-4, dass es Aufgaben wie akademische Examen, Prüfungen und Tests überdurchschnittlich erfolgreich bearbeiten kann. Dementsprechend werden in den Bereichen algebraische/mathematische Fähigkeiten, Sprachverständnis etc. erweiterte und komplexe Kompetenzen generiert.

- Mithilfe des neuen Features, der Bildeingabe, können User:innen Bilder einfügen. Daraufhin erstellt GPT-4 Interpretationen, Schlussfolgerungen und weitere diverse Erkenntnisse. Es können beispielsweise Webseiten generiert und Informationen von Dokumenten extrahiert werden.

- Des Weiteren glänzt GPT-4 mit einem veränderten Verhalten von KI. Eine Individualisierung des Modells durch entsprechende Formulierung der Anweisung ist dadurch ebenfalls im Bereich des Möglichen. Das heißt, es können Dialoge generiert werden, die auf vorherigen Konversationen mit dem Chatbot basieren.

- Ein weiterer Vorteil von GPT-4 im Vergleich zu GPT-3 ist der umfangreiche Datenzugriff. Infolgedessen kann GPT-4 mit weitaus vielfältigeren und größeren Datensätzen operieren und folglich trainiert werden.

GPT-4 – eine wahre KI-Revolution

Die bereits angesprochenen Datensätze und die daraus resultierenden Möglichkeiten sind ein weiterer Meilenstein im revolutionären Programm von GPT-4:

- Der größte Unterschied zwischen GPT-3 und GPT-4 zeigt sich in der Anzahl der Parameter, mit denen es trainiert wurde. GPT-3 wurde mit 175 Milliarden Parametern trainiert und ist damit das größte Sprachmodell, das je erstellt wurde. Im Vergleich dazu wird GPT-4 mit 100 Billionen Parametern trainiert.

- Die Textdatenkalkulation ist ein weiterer wichtiger Baustein von ChatGPT. Auch hierbei hat GPT-4 bezüglich der Datenmasse deutlich zugelegt. Der Umfang der Texteingabe bei ChatGPT wird in sogenannten „Tokens“ berechnet. Wie bereits erwähnt kann GPT-4 mehr Textdaten verarbeiten als GPT-3. Die Maximalanzahl bei GPT-4 beträgt 32 Tokens, während sie bei GPT-3 bei 8 Tokens liegt.

💡 Die GPT-Modellfamilie verarbeitet Text mithilfe von Tokens, bei denen es sich um übliche Zeichenfolgen handelt, die im Text vorkommen. Diese Modelle verstehen die statistischen Beziehungen zwischen diesen Tokens und zeichnen sich dadurch aus, dass sie das nächste Token in einer Folge von Tokens erzeugen. Die Berechnung dieser Tokens wird im von OpenAI eigens konzipierten „Tokenizer“ durchgeführt.

💡 Der Tokenizer zeigt, wie Prompts von ChatGPT beziehungsweise GPT-3, aber auch von anderen KI-Tools separiert werden. Ein bis zwei kurze englische Sätze entsprechen etwa 30 Tokens; zwei deutsche Sätze gleichen Inhalts können zuweilen doppelt so viele Tokens umfassen. OpenAI selbst gibt für GPT-3 und damit auch ChatGPT ein Limit von 4.097 Tokens an. Text, der über diese Grenze hinausgeht, wird von der Künstlichen Intelligenz ignoriert. Somit lassen sich anhand der Anzahl der Token auch die Kosten für den KI-User berechnen.

GPT-4 und Natural Language Processing

Mithilfe von selbstlernenden Spracherkennungssystemen, lassen sich die überaus komplexen Modelle von GPT-4 strukturiert aufbauen. Methoden und Techniken zur maschinellen Verarbeitung natürlicher Sprache spielen hierbei eine übergeordnete Rolle:

Natural Language Processing (NLP) versucht, natürliche Sprache zu erfassen und mithilfe von Regeln und Algorithmen computerbasiert zu verarbeiten. Hierfür werden verschiedene Methoden und Ergebnisse aus den Sprachwissenschaften verwendet und mit moderner Informatik und künstlicher Intelligenz kombiniert. Ziel ist es, eine möglichst weitreichende Kommunikation zwischen Menschen und Computer per Sprache zu erschaffen.

Folglich sollen sich sowohl Anwendungen als auch Maschinen per Sprache steuern und bedienen lassen. Da Computer nicht wie Menschen auf Erfahrungen zum besseren Verstehen von Sprache zurückgreifen können, müssen sie Algorithmen und Verfahren der KI und des Machine Learnings anwenden. NLP muss Sprache in Form von Schall oder Zeichenketten erfassen und den Sinn extrahieren, dafür gibt es verschiedene Methoden. Teilbereiche des NLP finden hierfür Anwendung:

- Spracherkennung

- Segmentierung zuvor erfasster Sprache in einzelne Wörter und Sätze

- Erkennen der Grundformen der Wörter und Erfassung grammatischer Informationen

- Erkennen der Funktionen einzelner Wörter im Satz

- Extraktion der Bedeutung von Sätzen und Satzteilen

- Erkennen von Satzzusammenhängen und Satzbeziehungen

GPT-4 und Large Language Models

Large Language Models (LLMs) sind ein Teil der Natural Language Processing (NLP)-Forschung, die sich mit der Entwicklung von Modellen beschäftigt, die natürliche Sprache verstehen und generieren können. Sie nutzen insbesondere die Technologie der neuronalen Netze, um das Verstehen und die Erstellung von Sprache zu ermöglichen. Ein LLM ist also ein spezielles Modell innerhalb von NLP, das auf eine Vielzahl von Aufgaben angewendet werden kann. Während NLP ein breiteres Feld ist, das sich mit der Verarbeitung und Analyse von natürlicher Sprache beschäftigt und LLMs ein Teil davon sind.

Das LLM ist fester Bestandteil in der Entwicklung von GPT-4. Die Daten, auf denen Large Language Models (LLMs) trainiert werden, stammen in der Regel aus öffentlich zugänglichen Quellen, wie dem Internet. Einige der am häufigsten verwendeten Datenquellen für das Training von LLMs sind:

- Wikipedia: Ein großer Teil der Daten, die für das Training von LLMs verwendet werden, stammt aus Wikipedia-Artikeln. Diese Artikel sind in viele verschiedene Sprachen übersetzt und decken eine breite Palette von Themen ab.

- Buch- und Artikeldatenbanken: LLMs werden oft auf Daten aus Büchern und wissenschaftlichen Artikeln trainiert, die in Online-Datenbanken zugänglich sind.

- Soziale Medien: Tweets, Posts und andere soziale Medien-Inhalte werden oft verwendet, um LLMs zu trainieren, da sie eine große Menge an natürlicher Sprache enthalten.

- Andere öffentlich verfügbare Quellen wie Nachrichtenartikel, Forum-Beiträge und Online-Kommentare

Neuerungen mit GPT-4o und GPT-o1

GPT-4o

Das neue Modell von GPT-4 wird nun durch ein O ergänzt. In diesem Fall steht es für Omni, da das Modell Bilder, Texte und Audios verarbeiten kann. Dabei soll es doppelt so schnell und 50% günstiger sein, als der Vorgänger Chat-CPTturbo. Dass Modell wird außerdem um eine Desktop App für Mac Nutzer ergänzt und reagiert damit vorausschauend auf die Einbindung der verschiedenen Browser von eigenen KI-Modellen. Bisher ist das GPT-4o Modell für alle Nutzer kostenlos (wobei die Anzahl der Anfragen gedeckelt wird).

Das neue Modell kann Kontextbezogen mitdenken und weiterhelfen, die größten Sprünge gibt es allerdings bei der Audioverarbeitung. Auf audioeingaben kann in nur 232 ms reagiert werden, das ist fast so schnell wie in einem natürlichen Gespräch zwischen zwei Menschen. Außerdem kann die KI ruhige von aufgeregten Atemzügen unterscheiden und Emotionen in synthetischer Sprache ausdrücken. Videos und Fotos können live analysiert werden, um Emotionen zu erkennen.

Die bisherigen Modelle hatten häufiger Schwierigkeiten mit Humor, was im neuen Modell verbessert wurde, gleichzeitig erfindet GPT-4o deutlich weniger Antworten, also noch seine Vorgänger.

GPT-o1

Der größte Unterschied zu anderen Modellen liegt bei GPT-o1 darin, dass es nach dem Chain of Thougt Prinzip handelt. Das Problem wird dabei in kleinere Abschnitte eingeteilt, welche nacheinander durchgearbeitet werden. Führt ein Abschnitt nicht zur Lösung werden andere Möglichkeiten im Hintergrund durchgespielt. Das Modell soll erst einmal alles hinterfragen, was dazu führt, dass die Qualität der Antworten im Vordergrund steht und nicht die Schnelligkeit. Darum eignet sich das GPT-o1 Modell besonders für komplexere Aufgaben wie in Mathematik, Coding und wissenschaftlichen Arbeiten.

Eine weitere Entwicklung ist das GPTo1-mini, welches günstiger und schneller in der Anwendung ist und sich besonders gut für logisches Schritt-für-Schritt denken eignet. Das GPT-o1 Modell ist allerdings mit einem breiteren Hintergrundwissen ausgestattet, sollte dies für die Fragestellung relevant sein, ist man dennoch mit dem o1 Modell besser beraten.

Fazit: Schnelle Entwicklungen bei Chat GPT

Es gibt auch einige Unternehmen und Organisationen, die ihre eigenen Daten für das Training von LLMs verwenden, insbesondere wenn sie spezifische Anwendungen haben, die von den Modellen unterstützt werden sollen. Diese Daten können beispielsweise aus Kundenfeedback, E-Mails oder Chatprotokollen stammen.

Abschließend kann konstatiert werden, dass OpenAI mit GPT-4 ein herausragend komplexes und fortschrittliches KI-Modell entwickelt und in geringem Zeitraum nach der Veröffentlichung von GPT-3 beeindruckende Features und enorme Datenstrukturen hinzugewonnen hat. Der technische Fortschritt zeigt sich in seiner Schnelligkeit immer wieder in den verbesserten Chat GPT Modellen.

Wir sind unglaublich gespannt auf die weiteren Entwicklungen im Markt und sind immer dabei diese Innovationen in unsere Plattform, melibo, einzubauen.